1.robots是什么?

很多新人容易忽略的robots.txt,所以这期来详细的讲解一下robots.txt。

robots是机器人语言,是给蜘蛛看的,而不是给人看的。

它是一个文本文件,以.txt的形式存放在网站的根目录,任何搜索引擎都会第一时间访问robots.txt文件。

2.robots的作用

robots的作用相当于你去别人家里做客,主人会带你去参观屋子,这些是能看的。主人还会告诉你,卧室不能进入,这些是不能看的。

稍微有礼貌的客人就会知道哪些地方是能去的,哪些地方是不能去的。

这就是robots的作用,它会告诉搜索引擎的蜘蛛,你哪里可以去看,哪里不能去看。

3.robots的创建和使用

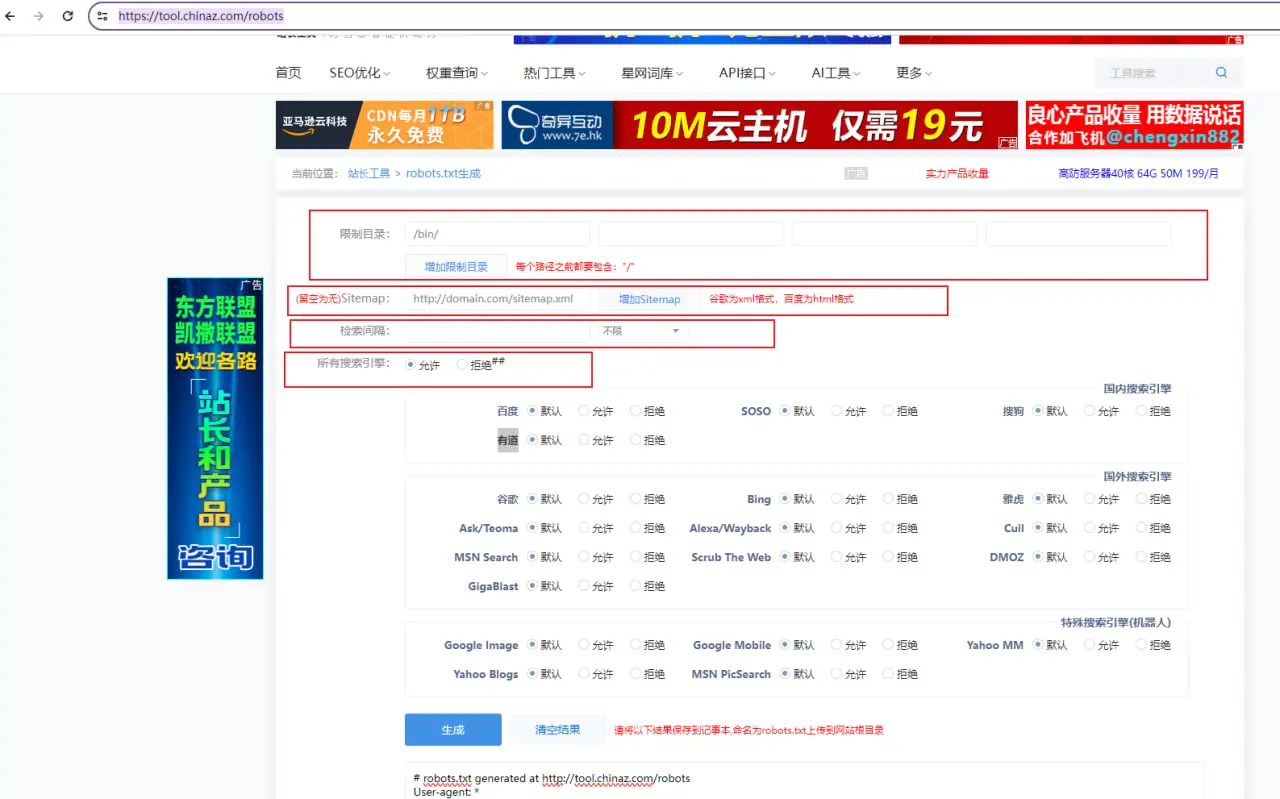

我一般会借助在线工具,比如站长直接或者是爱站,这里演示使用站长之家的robots在线生成工具。

访问:https://tool.chinaz.com/robots

【限制目录】:一般放admin,user,upload等敏感目录,这些目录不需要收录和排名,所以需要我们屏蔽它们。

【sitemap】:这里是放我们的网站sitemao的地方,有几个放几个。

【检索间隔】:这个是告诉搜索引擎,你多久来一次可以。就跟你不希望你的朋友每天都来找你喝酒一样,你希望搜索引擎多久来一次。当然这个有些搜索引擎遵守,有些搜索引擎不接受,有肯定好过没有。

【所有搜索引擎】:这里选择允许的话就是所有搜索引擎都允许,你要一个个去屏蔽不需要的搜索引擎蜘蛛。

如果你默认拒绝的话,那就要给允许的搜索引擎蜘蛛放开。

搜索引擎大全:

Ask/Teoma是美国的一个搜索引擎。由美国的Ask Jeeves公司开发并推出,全球搜索份额少。

Bing是微软公司开发的一种网络搜索引擎,新电脑一般都会先用IE浏览器进行搜搜,那个就是bing搜索,有一定的市场份额,毕竟是微软自家的产品。

雅虎搜索(Yahoo Search)是雅虎公司的搜索引擎,搜索份额少。

Alexa/Wayback,中文名【回溯机】,一般都会称呼它为【时光机】,是用来记录网站快照的,屏蔽这个蜘蛛也没有什么的,只是不让人看你的历史快照。

Cuil搜索,由谷歌的前员工创建,于2010年倒闭。

MSN Search,bing的前身,不屏蔽就行。

Scrub The Web,极其少的人在使用。

DMOZ(Open Directory Project),2017年倒闭。

GigaBlast,美国GigaBlast公司开发,号称不会收集用户的搜索隐私,市场份额较小。

Yahoo MM,yahoo的蜘蛛。

Yahoo Blogs,yahoo的蜘蛛。

MSN PicSearch,bing前身的蜘蛛,还有没有在使用也不清楚。

SOSO,腾讯家的产品,份额小。

有道,网易家的产品,份额小。

谷歌,谷歌就不用说了,世界第一搜索引擎。

百度,百度在国内也是行业龙头的位置。

搜狗,腾讯收购了搜狗,现在微信公众号是可以在搜狗上面进行排名的,份额较大。

360,由奇虎360(Qihoo 360)开发和运营,份额较小。

神马,神马搜索是移动公司家推出的产品,只做移动端市场,早几年势头很火,现在市场份额也小。

夸克,阿里巴巴家推出的产品,曾经想搜索什么都能搜索得到,是什么都能搜索得到!后面被监管后也渐渐萎靡,现在的市场份额也小。

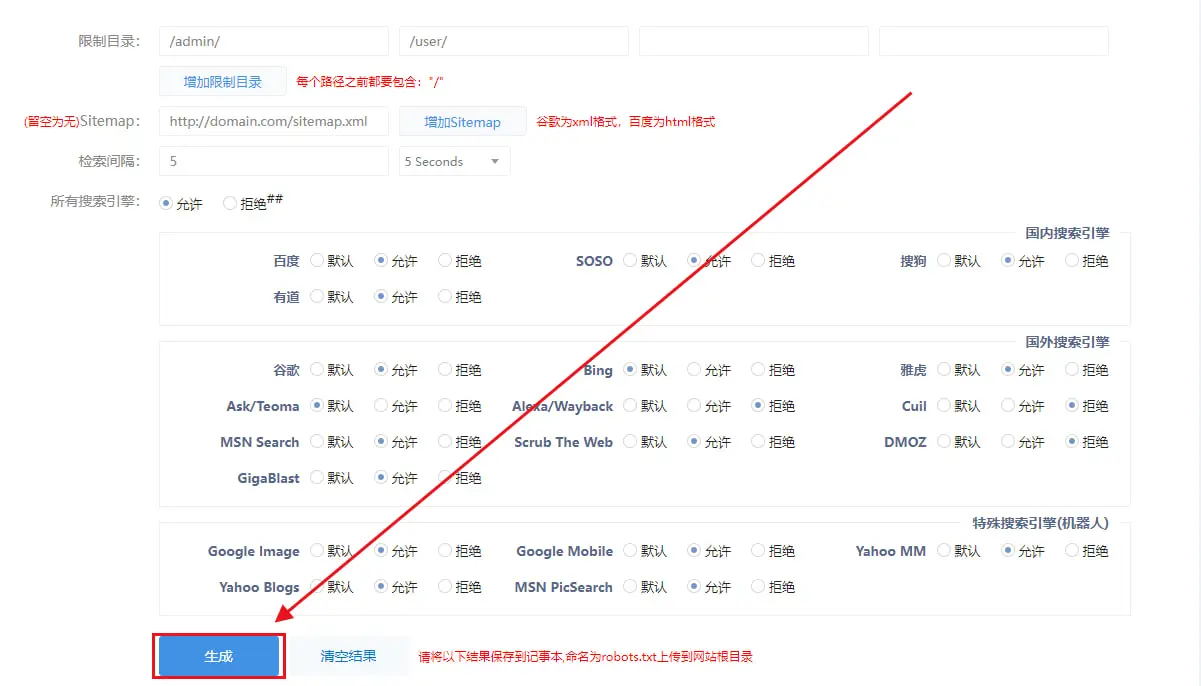

我们接下来生成一个robots演示演示:

我们配置好后点击【生成】

生成robots后,这里会有一行的代码,这个是站长之家自带的代码,我们删掉就可以了。

User-agent: Baiduspider

Disallow:

User-agent: Sosospider

Disallow:

User-agent: sogou spider

Disallow:

User-agent: YodaoBot

Disallow:

User-agent: Googlebot

Disallow:

User-agent: Slurp

Disallow:

User-agent: ia_archiver

Disallow: /

User-agent: twiceler

Disallow: /

User-agent: MSNBot

Disallow:

User-agent: Scrubby

Disallow:

User-agent: Robozilla

Disallow: /

User-agent: Gigabot

Disallow:

User-agent: googlebot-image

Disallow:

User-agent: googlebot-mobile

Disallow:

User-agent: yahoo-mmcrawler

Disallow:

User-agent: yahoo-blogs/v3.9

Disallow:

User-agent: psbot

Disallow:

Crawl-delay: 5

Disallow: /admin/

Disallow: /user/

Sitemap: http://domain.com/sitemap.xml

以上就是我们生成的robots代码,我们复制这些代码,然后打开网站的根目录。

点击新建空白文件,改名为robots.txt

把代码粘贴到robots.txt中,然后保存文件就可以了。

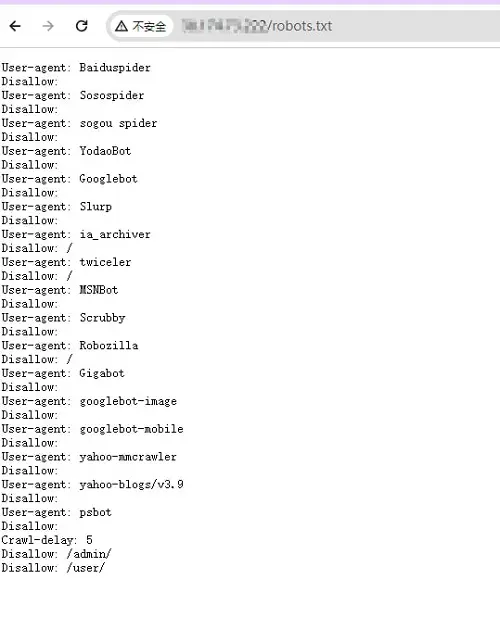

保存好后我们访问robots检查一下,看看能不能正常打开。

以上就是本期robots.txt的教程,robots虽然是少枝末节,但也是颇为有用。